Web Scraping cos’è e come farlo in maniera LEGALE

- 24 Novembre 2024

- Guide SEO

Il web scraping è una tecnica che permette di estrarre dati dal web in modo automatico, trasformandoli in informazioni utili e facilmente analizzabili. In un mondo sempre più digitale, dove i dati rappresentano una risorsa fondamentale per aziende e professionisti, è importante capire che cos’è il web scraping e come viene utilizzato.

Grazie allo scraping web, è possibile raccogliere grandi quantità di informazioni in poco tempo, eliminando la necessità di fare ricerche manuali. Questo processo è diventato essenziale per chi lavora nel marketing, nell’e-commerce, nell’analisi dei dati e in molti altri settori. Ma non è solo questione di velocità: il web scraping consente anche di automatizzare attività complesse, rendendo tutto più efficiente e parliamoci chiaro, arrivare alle prime posizioni su google.

In questo articolo scoprirai cos’è il web scraping, come funziona e quali strumenti puoi utilizzare per sfruttarlo al meglio. Analizzeremo anche i suoi utilizzi pratici, i vantaggi e le problematiche legali che potrebbero sorgere perché alcune informazioni in mani sbagliate potrebbero essere utilizzate per fare siti black hat.

Cos’è il web scraping?

Per capire cos’è il web scraping, immagina di visitare manualmente un sito web per copiare informazioni come prezzi, descrizioni di prodotti o dati di contatto. Ora pensa di automatizzare questo processo: lo scraping web fa esattamente questo, ma in modo rapido e scalabile. Si tratta di una tecnica che utilizza strumenti software per accedere ai siti web, analizzarne il contenuto e salvare i dati in un formato strutturato, come un foglio di calcolo o un database.

Che cos’è il web scraping in termini pratici? È una metodologia che consente di estrarre dati pubblici disponibili online, come ad esempio:

- Prezzi dei prodotti in un e-commerce per confronti di mercato.

- Recensioni e commenti sui social media per analisi delle opinioni.

- Dati di ricerca su immobili, voli o hotel per creare report personalizzati.

Lo scraping web si basa su bot automatizzati, piccoli programmi che navigano tra le pagine di un sito, leggono il codice HTML e identificano le informazioni da estrarre.

Sì, lo fanno i SEO che utilizzano tecniche black hat.

Questo processo può essere semplice, come raccogliere titoli da un blog, oppure complesso, richiedendo script avanzati per superare barriere come CAPTCHA o restrizioni di accesso.

Come funziona il web scraping?

Il web scraping segue un processo in tre fasi principali:

- Accesso al sito web: Lo scraper accede al contenuto del sito come farebbe un utente normale, utilizzando tecniche come richieste HTTP.

- Analisi del codice HTML: Il programma identifica gli elementi di interesse (testo, immagini, link) attraverso il codice sorgente della pagina.

- Estrazione e salvataggio: I dati vengono estratti e organizzati in un formato utilizzabile, come file CSV, JSON o direttamente in un database.

Differenza tra scraping manuale e automatico

Lo scraping manuale richiede di copiare e incollare i dati manualmente, una soluzione poco pratica per grandi volumi di informazioni. Al contrario, il web scraping automatizzato utilizza software specifici che possono navigare tra centinaia di pagine in pochi minuti, rendendo l’intero processo più veloce e scalabile.

Cos’è lo scraping web se non uno strumento potente per chiunque voglia sfruttare al massimo le informazioni online che insieme ad una bella dose di backlink ti permette di esplodere subito nei risultati di Google?

A cosa serve il web scraping?

Il web scraping è diventato uno strumento indispensabile in diversi ambiti professionali e industriali. Grazie alla capacità di raccogliere dati pubblici in modo rapido e organizzato, è possibile utilizzarlo in una vasta gamma di applicazioni. E se ci stiamo chiedendo che cos’è il web scraping e ci fermiamo solamente al “mondo black hat” ci stiamo perdendo anche un utilizzo molto importante, ovvero quello di utilizzarlo come un mezzo per trasformare il caos dei dati online in informazioni preziose.

Utilizzi pratici del web scraping

Ecco alcuni esempi di come lo scraping web venga impiegato concretamente:

Monitoraggio dei prezzi

Le aziende e i privati utilizzano il web scraping per raccogliere informazioni sui prezzi dei prodotti da siti concorrenti. Questo è particolarmente utile nell’e-commerce per:

- Analisi della concorrenza: Identificare strategie di prezzo per migliorare la propria offerta.

- Comparazione dei prezzi: Creare servizi di confronto automatico per i consumatori.

Analisi di mercato

Cos’è lo scraping web senza la possibilità di raccogliere dati utili per le ricerche di mercato? Consente di:

- Raccogliere feedback da recensioni di prodotti.

- Studiare i trend del settore analizzando post sui social media o articoli di notizie.

Generazione di lead

Molte aziende lo usano per ottenere elenchi di contatti pubblici, come email o numeri di telefono, per costruire database di potenziali clienti. È importante sottolineare, però, che questi utilizzi devono rispettare le normative sulla privacy.

Automatizzazione di attività ripetitive

Lo scraping web semplifica lavori che altrimenti richiederebbero ore o giorni, come:

- Raccolta di dati da portali immobiliari.

- Acquisizione di informazioni da siti di viaggi per analisi su voli e hotel.

Vantaggi per il marketing e la SEO

Per i professionisti del marketing, il web scraping è una risorsa preziosa per:

- Analisi delle parole chiave: Raccogliere keyword rilevanti dai siti concorrenti.

- Controllo dei backlink: Monitorare i link ricevuti dai competitor o siti di riferimento.

Il web scraping e l’intelligenza artificiale

In molti progetti basati su AI e machine learning, i dati raccolti tramite scraping vengono utilizzati per addestrare modelli, come chatbot o sistemi di raccomandazione.

Lo scraping web, dunque, non è solo uno strumento per raccogliere dati, ma un mezzo per creare valore e prendere decisioni strategiche basate su informazioni solide.

Strumenti e linguaggi per il web scraping

Per sfruttare al meglio il web scraping, è essenziale conoscere gli strumenti e i linguaggi di programmazione più utilizzati. Non importa se sei un principiante o un esperto: oggi esistono soluzioni adatte a ogni livello di competenza, da strumenti semplici e intuitivi a framework avanzati per sviluppatori.

I migliori strumenti per il web scraping

Ecco una panoramica dei tool più popolari per fare scraping web:

Beautiful Soup

Uno dei framework più conosciuti, basato su Python. È ideale per analizzare e manipolare file HTML e XML, perfetto per progetti di piccola o media complessità. È semplice da imparare, il che lo rende una scelta ottima per i principianti che vogliono capire che cos’è il web scraping e iniziare subito a lavorare.

Scrapy

Un framework Python avanzato per scraping su larga scala. È progettato per creare crawler personalizzati e gestire grandi quantità di dati. Scrapy offre funzionalità integrate come la gestione di richieste HTTP e il supporto per l’estrazione di dati strutturati, rendendolo uno strumento molto potente.

Selenium

Se il sito web da cui vuoi estrarre dati utilizza JavaScript per caricare contenuti (ad esempio attraverso tecnologie come AJAX), Selenium è una soluzione ideale. Non è solo uno strumento di web scraping, ma anche una libreria per il test di applicazioni web, utile per simulare l’interazione con un browser.

Octoparse

Un tool no-code che permette di fare web scraping senza scrivere una riga di codice. La sua interfaccia drag-and-drop lo rende accessibile a chiunque, anche a chi non ha competenze tecniche.

ParseHub

Simile a Octoparse, ParseHub è un tool visuale che consente di raccogliere dati da siti complessi con un approccio guidato. Perfetto per chi cerca una soluzione rapida e intuitiva.

Linguaggi di programmazione per il web scraping

Lo scraping web si basa principalmente su linguaggi di programmazione versatili e adatti alla manipolazione di dati. Ecco i più comuni:

Python

Python è il re del web scraping grazie alla sua semplicità e alle numerose librerie dedicate come Beautiful Soup, Scrapy e Pandas. È la scelta preferita per chi vuole imparare velocemente cos’è lo scraping web e metterlo in pratica.

R

Spesso utilizzato in analisi statistica, R può essere un’ottima scelta per scraping in combinazione con analisi avanzate. Le librerie come rvest rendono semplice l’estrazione e la visualizzazione dei dati.

JavaScript

JavaScript, insieme a Node.js, è utile per scraping dinamico, soprattutto per siti che caricano contenuti tramite AJAX. Librerie come Puppeteer permettono di interagire con il DOM e gestire le richieste in tempo reale.

PHP

Anche se meno popolare per lo scraping rispetto a Python, PHP offre librerie come Simple HTML DOM Parser, utili per piccoli progetti.

Molti strumenti di web scraping sono gratuiti, il che li rende ideali per chi sta iniziando. Tuttavia, per progetti più complessi o su larga scala, può essere utile investire in software a pagamento che offrono maggiore affidabilità, velocità e supporto tecnico.

Conoscere gli strumenti e i linguaggi giusti è fondamentale per iniziare a utilizzare il web scraping in modo efficace.

Aspetti legali e best practice del web scraping

Il web scraping è una pratica potente e utile, ma non è priva di controversie legali ed etiche. Molte persone si chiedono: è legale il web scraping? La risposta non è sempre semplice, perché dipende da come viene effettuato e da quali dati vengono estratti. In questo capitolo analizzeremo i principali aspetti legali dello scraping web e come rispettare le regole per evitare problemi.

È legale fare web scraping?

Non esiste una risposta unica: la legalità del web scraping varia in base alla giurisdizione e al contesto. In generale, il principio fondamentale è che i dati pubblici possono essere raccolti, ma con alcune limitazioni. Ecco i fattori principali da considerare:

Termini di servizio del sito web

Molti siti web specificano nei loro termini di servizio che è vietato utilizzare bot o software di scraping per raccogliere dati. Violare queste condizioni potrebbe portare a blocchi o a conseguenze legali, anche se i dati sono tecnicamente accessibili al pubblico.

Copyright e proprietà intellettuale

Anche se i dati sono pubblici, il loro utilizzo può violare il copyright o i diritti di proprietà intellettuale. Ad esempio, copiare interamente i contenuti di un sito web per riutilizzarli potrebbe essere considerato un’infrazione.

Protezione dei dati personali

Se stai raccogliendo dati sensibili o personali, come indirizzi email o numeri di telefono, devi rispettare le normative sulla privacy, come il GDPR in Europa o il CCPA in California. Queste leggi impongono limiti severi sull’uso dei dati personali.

Best practice per uno scraping web etico e legale

Per evitare problemi e fare scraping in modo responsabile, segui queste linee guida:

Rispettare i file robots.txt

Molti siti includono un file robots.txt che indica quali pagine possono essere visitate dai bot. Anche se tecnicamente non è obbligatorio rispettarlo, ignorarlo può causare problemi legali o portare al blocco del tuo bot.

Non sovraccaricare i server

Evitare di inviare troppe richieste in poco tempo è fondamentale. Il sovraccarico di un server può essere interpretato come un attacco DDoS e potrebbe portare a conseguenze legali o al blocco del tuo IP.

Ottenere il consenso

Se possibile, richiedi il permesso del proprietario del sito prima di avviare il processo di scraping. Questo è particolarmente importante per i dati sensibili o proprietari.

Usare i dati in modo responsabile

Assicurati che i dati raccolti vengano utilizzati solo per scopi legittimi, come analisi di mercato o ricerche personali, e non per scopi fraudolenti o non etici.

Non superare i limiti

Se il sito offre un’API, utilizza quella per raccogliere i dati invece di ricorrere allo scraping. Le API spesso forniscono accesso legale e strutturato alle informazioni.

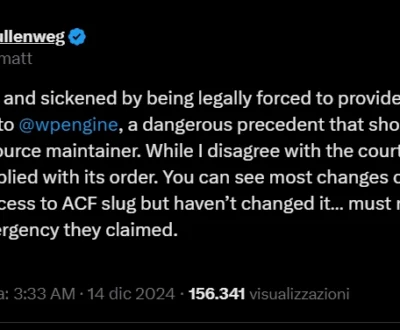

Casi famosi legati alla legalità del web scraping

Esistono numerosi casi legali che hanno coinvolto aziende e professionisti accusati di fare scraping illecito. Ad esempio, LinkedIn ha citato in giudizio società per aver estratto informazioni dai profili pubblici dei suoi utenti senza consenso. Questi esempi evidenziano l’importanza di rispettare le regole e agire con prudenza.

Come iniziare con il web scraping

Se sei affascinato dal potenziale del web scraping, iniziare è più semplice di quanto immagini. Con gli strumenti e le risorse giuste, anche un principiante può imparare rapidamente le basi di questa tecnica. Ora vedremo i primi passi per avviare un progetto di scraping web e alcune raccomandazioni utili per iniziare, ma mi raccomando, fatelo con correttezza!

I primi passi per fare web scraping

Scegliere uno strumento o un linguaggio

Il primo passo è selezionare lo strumento o il linguaggio di programmazione più adatto al tuo progetto. Per chi è alle prime armi, Python è la scelta ideale grazie alla sua semplicità e alle numerose librerie dedicate come:

- Beautiful Soup: Ottimo per analizzare e manipolare il codice HTML.

- Scrapy: Perfetto per progetti più complessi e scraping su larga scala.

- Selenium: Ideale per siti web dinamici.

Se non hai competenze di programmazione, puoi optare per strumenti visivi come Octoparse o ParseHub, che non richiedono conoscenze tecniche.

Installare l’ambiente di lavoro

Se scegli Python, segui questi passaggi per impostare il tuo ambiente di lavoro:

- Scarica e installa Python dal sito ufficiale.

- Installa un editor di codice come Visual Studio Code o PyCharm.

- Usa il terminale per installare le librerie necessarie, ad esempio:

pip install beautifulsoup4

pip install requestsIdentificare il sito e i dati da estrarre

Prima di iniziare a scrivere il codice, esplora il sito da cui vuoi raccogliere i dati. Analizza il codice sorgente della pagina (clic destro → “Ispeziona elemento” nel browser) per identificare gli elementi HTML contenenti le informazioni che ti interessano.

Scrivere il tuo primo script

Ecco un esempio di base con Beautiful Soup per estrarre titoli da un blog:

import requests

from bs4 import BeautifulSoup

# URL del sito da cui fare scraping

url = 'https://esempio.com'

# Richiesta HTTP per ottenere il contenuto della pagina

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

# Estrazione dei titoli

for title in soup.find_all('h2'):

print(title.text)Salvare i dati

Puoi salvare i dati estratti in un file CSV o in un database per un utilizzo successivo. Python offre librerie come csv o pandas per gestire facilmente questa operazione.

Raccomandazioni per principianti

- Inizia con progetti semplici: Come estrarre i titoli delle notizie o i prezzi di un e-commerce. Questo ti aiuterà a capire il processo senza complicarti troppo.

- Fai attenzione agli aspetti legali: Prima di iniziare, leggi i termini di servizio del sito per assicurarti di rispettare le regole.

- Usa strumenti di debugging: Strumenti come Postman o l’inspect tool del browser possono aiutarti a testare e perfezionare le tue richieste.

Progetti iniziali consigliati

Se non sai da dove cominciare, prova uno di questi progetti:

- Creare un elenco dei titoli degli articoli di un sito di notizie.

- Estrarre i prezzi dei prodotti da un e-commerce per un confronto.

- Raccogliere informazioni sugli eventi di una città da siti di turismo.

Serve il web scarping o è solo black hat?

Il web scraping è molto più di una semplice tecnica per raccogliere dati: è uno strumento potente che, se usato correttamente, può offrire un vantaggio competitivo significativo in qualsiasi settore. Personalmente, ritengo che il vero valore del web scraping risieda nella sua capacità di democratizzare l’accesso ai dati. In un’epoca in cui le informazioni sono la moneta più preziosa, poterle estrarre e utilizzare in modo strategico significa avere un enorme potenziale tra le mani.

Come sempre c’è un equilibrio delicato tra utilizzo etico e abuso. È fondamentale rispettare le leggi, i termini di servizio dei siti web e le normative sulla privacy. Questo non è solo un obbligo legale, ma anche una questione di rispetto per il lavoro altrui e per gli utenti i cui dati vengono analizzati.

Dal mio punto di vista, il web scraping è come un coltellino svizzero: straordinario se usato con attenzione, ma pericoloso se non sai cosa stai facendo. È un’abilità che vale la pena imparare, sia che tu sia un programmatore esperto sia che tu stia cercando di automatizzare un’attività. Gli strumenti oggi disponibili la rendono accessibile a chiunque, eliminando molte delle barriere tecniche che esistevano in passato.

Se hai mai pensato di sperimentare con lo scraping web, ti incoraggio a farlo con consapevolezza. Parti da piccoli progetti e scoprirai quanto può essere affascinante dare ordine al caos dei dati online. Ma non dimenticare mai che con il grande potere arriva anche una grande responsabilità: usa questa tecnica per creare valore, non per infrangere regole.