Googlebot: Come Funziona il crawler di Google?

- 28 Novembre 2024

- Guide SEO

Capire come funziona il Googlebot è fondamentale per chiunque voglia migliorare la visibilità del proprio sito web. Il crawler di Google, noto anche come il “bot di Google”, è uno strumento essenziale per il motore di ricerca, responsabile di scansionare e indicizzare le pagine presenti sul web. Ma cosa significa realmente? E come possiamo ottimizzare il nostro sito affinché questo strumento lavori al meglio per noi e fare il nostro gioco con la SEO?

In parole semplici, il Googlebot è il software che Google utilizza per raccogliere informazioni sui contenuti online, decidendo quali pagine meritano di essere inserite nel suo indice. È attraverso questo processo che le pagine possono essere trovate dagli utenti quando cercano qualcosa su Google. Comprendere cos’è il Googlebot, il suo ruolo e come funziona permette di adottare strategie SEO più efficaci, garantendo che i contenuti vengano rilevati, analizzati e mostrati nei risultati di ricerca.

Il lavoro del Googlebot si divide principalmente in due fasi: crawling e indicizzazione. Durante il crawling, il bot esplora il web seguendo i collegamenti ipertestuali per scoprire nuove pagine o aggiornamenti su quelle già note. Successivamente, nella fase di indicizzazione, analizza e archivia queste informazioni per renderle disponibili nell’indice di Google.

Molti non sanno che ci sono diverse varianti del Googlebot, come il Googlebot Mobile e il Googlebot Desktop, ciascuno progettato per ottimizzare l’esperienza di navigazione a seconda del dispositivo utilizzato. Per chi gestisce un sito, è importante sapere come controllare l’attività del Googlebot attraverso strumenti come la Google Search Console e configurare correttamente il file robots.txt per guidare il bot verso le pagine che si desidera rendere visibili.

Comunque le chiacchiere stanno a 0, perché se il tuo sito non è ottimizzato, potresti incorrere in problemi come una scarsa frequenza di scansione o addirittura il mancato inserimento delle tue pagine nell’indice di Google. È qui che entrano in gioco strategie per migliorare il crawl budget, configurare il user-agent Googlebot e monitorare i log del server per assicurarti che il bot stia facendo il suo lavoro correttamente.

Grazie a Herolink scopriremo in dettaglio come il Googlebot opera, quali sono le migliori pratiche SEO per ottimizzarne l’attività e come evitare errori comuni che potrebbero compromettere la visibilità del tuo sito.

Tutte queste informazioni sono state prese e rielaborate dalla fonte di ufficiale di Developers Google

Cos’è il Googlebot?

Il Googlebot è il cuore pulsante del motore di ricerca di Google. Si tratta di un user-agent, ovvero un software automatizzato progettato per esplorare e raccogliere informazioni dal web. Ogni volta che un utente cerca qualcosa su Google, il lavoro del Googlebot è già stato completato: ha scansionato miliardi di pagine, analizzandole e organizzandole in modo che i risultati più pertinenti vengano mostrati in pochi istanti.

Il Ruolo del Googlebot nella SEO

Il compito principale del Googlebot è quello di visitare continuamente i siti web per scoprire nuove pagine o aggiornare le informazioni su quelle già esistenti. Questo processo, chiamato crawling, permette a Google di costruire un indice sempre aggiornato, essenziale per fornire risultati di ricerca accurati e tempestivi.

Ma cosa fa il Googlebot esattamente durante il crawling? Segue i collegamenti ipertestuali presenti sulle pagine per navigare tra siti e scoprire nuovi contenuti. Quando trova una pagina, ne analizza la struttura, i contenuti, i metadati e persino gli elementi multimediali per valutarne la qualità e la pertinenza ed ecco perché ogni volta insisto nel dire che l’internal linking è fondamentale!

Faciliti il passaggio del crawl e gli permetti di far conoscere il sito! Se non ci sono pagine collegate, queste Google faticherà a conoscerle e di conseguenza ad indicizzarle!

Crawling e Indicizzazione: Due Facce della Stessa Medaglia

Una volta completato il crawling, il Googlebot passa alla fase di indicizzazione. Qui, i dati raccolti vengono analizzati più a fondo e organizzati in un archivio strutturato, noto come l’indice di Google. Questo processo consente a Google di mostrare rapidamente le pagine più rilevanti quando viene effettuata una ricerca.

La differenza tra crawling e indicizzazione è fondamentale e molti nel mondo della SEO ancora non l’hanno capita, quindi leggi bene: il primo riguarda l’esplorazione del web, mentre il secondo si concentra sull’analisi e sull’organizzazione delle informazioni trovate.

Non tutte le pagine scansionate finiscono nell’indice; quelle di bassa qualità o con errori tecnici potrebbero essere escluse.

Come fare per capire se sono indicizzate ti stai chiedendo? Perché non hai letto l’articolo sugli operatori di ricerca di Google si vede!

Come Funziona il Googlebot: Crawling e Indicizzazione

Per capire come il Googlebot lavori dietro le quinte, è fondamentale approfondire le due fasi principali che ne definiscono il funzionamento: il crawling e l’indicizzazione. Questi processi sono il cuore dell’attività del bot e determinano se e come le pagine del tuo sito vengono visualizzate nei risultati di ricerca, vediamo nel dettaglio come si muove il ragnetto di Google.

Crawling: Come il Googlebot Scansiona il Web

Il crawling è il primo passo del lavoro del Googlebot. Durante questa fase, il bot esplora il web seguendo i collegamenti ipertestuali tra le pagine. L’obiettivo è scoprire nuovi contenuti o rilevare aggiornamenti su pagine già conosciute.

Il processo parte da un elenco di URL prioritari, noto come seed list, che Google aggiorna costantemente. Il bot segue i link trovati in queste pagine per espandere la sua rete di scansione. Le pagine scoperte vengono analizzate e classificate in base a criteri come rilevanza, qualità e accessibilità.

Ma cosa succede se il Googlebot non riesce a scansionare una pagina? I motivi possono essere diversi:

- File robots.txt mal configurati, che bloccano il bot.

- Errori nel server che impediscono l’accesso.

- Un’architettura del sito complessa o priva di collegamenti interni chiari.

È qui che entrano in gioco strategie di ottimizzazione, come garantire una buona struttura dei link interni e configurare correttamente il file robots.txt per guidare il Googlebot verso le pagine che vuoi indicizzare.

Indicizzazione: Cosa Succede Dopo il Crawling

Una volta che il Googlebot ha scansionato una pagina, il passo successivo è l’indicizzazione. In questa fase, Google analizza in profondità il contenuto della pagina per determinare cosa includere nel suo indice. L’indice è una sorta di gigantesca libreria digitale in cui vengono archiviati tutti i contenuti che Google ritiene utili e rilevanti.

Durante l’indicizzazione, il bot valuta:

- La qualità del contenuto (originalità, completezza, pertinenza).

- L’uso di parole chiave nei punti strategici (titoli, meta description, testo).

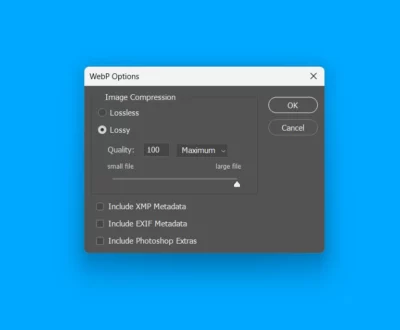

- La velocità e la compatibilità del sito con i dispositivi mobili.

- Gli elementi multimediali, come immagini e video, che devono essere ottimizzati con tag ALT e descrizioni appropriate.

Non tutte le pagine scansionate vengono indicizzate. Pagine duplicate, contenuti di bassa qualità o quelle che presentano errori tecnici (come redirect infiniti) rischiano di essere escluse e di conseguenza il tuo articolo non finirà mai in prima pagina!

La Frequenza di Crawling e il Crawl Budget

La frequenza di crawling del Googlebot dipende da diversi fattori, tra cui la qualità del sito e la frequenza con cui viene aggiornato. Per i siti di alta qualità, il bot tende a visitare più frequentemente, mentre per quelli con errori tecnici o contenuti statici le visite possono essere sporadiche.

Un altro concetto chiave è il crawl budget, ovvero il numero massimo di pagine che il Googlebot è disposto a scansionare durante una sessione. Questo limite varia da sito a sito ed è influenzato da fattori come:

- La velocità del server.

- La struttura del sito.

- La presenza di errori che rallentano o ostacolano il crawling.

Ottimizzare il crawl budget significa garantire che il bot utilizzi il tempo a disposizione per scansionare le pagine più importanti del tuo sito, evitando di sprecare risorse su contenuti inutili o pagine non rilevanti.

Strumenti per Monitorare il Crawling e l’Indicizzazione

Per sapere esattamente come il Googlebot interagisce con il tuo sito, strumenti come la Google Search Console sono essenziali. Qui puoi:

- Verificare quali pagine sono state scansionate e indicizzate.

- Individuare errori di crawling.

- Richiedere l’indicizzazione di pagine nuove o aggiornate.

Analizzare i log del server può inoltre offrire informazioni dettagliate sulle attività del bot, come quali pagine visita più spesso o eventuali errori incontrati.

Ottimizzare il Tuo Sito per il Googlebot

Ottimizzare il tuo sito per il Googlebot non significa solo rendere più semplice la scansione e l’indicizzazione, ma anche migliorare la qualità complessiva del tuo sito per garantire che Google riconosca e valorizzi i tuoi contenuti per portarli ai primi posti in SERP.

Migliorare il Crawl Budget

Il crawl budget rappresenta il numero di pagine che il Googlebot scansiona durante una sessione sul tuo sito. Ottimizzarlo significa assicurarti che il bot si concentri sulle pagine più rilevanti e non sprechi risorse su contenuti secondari o inutili. Sì. è un po’ come funziona quando lo passi su Screaming Frog se te lo stai chiedendo, entra da una pagina, segue i link ed analizza il tutto.

Ecco alcune azioni pratiche:

- Rimuovi o blocca i contenuti inutili: Pagine duplicate, URL con parametri inutili e contenuti di bassa qualità possono essere esclusi tramite il file robots.txt o tag noindex.

- Ottimizza la struttura interna dei link: Una buona rete di collegamenti interni guida il Googlebot verso le pagine più importanti del tuo sito.

- Riduci i tempi di caricamento del sito: Un server lento può limitare il numero di pagine che il Googlebot è in grado di scansionare.

Configurare Correttamente il File Robots.txt

Il file robots.txt è una delle prime cose che il Googlebot controlla quando visita il tuo sito. Questo file indica quali pagine il bot può o non può scansionare. Una configurazione corretta aiuta a evitare errori come:

- Bloccare accidentalmente pagine importanti.

- Consentire al Googlebot di accedere a risorse essenziali come file CSS e JavaScript.

Un esempio di configurazione utile potrebbe essere:

User-agent: Googlebot

Disallow: /pagina-non-importante/

Allow: /

Assicurati di testare il file robots.txt utilizzando strumenti come la Google Search Console per verificare che funzioni correttamente.

Creare e Aggiornare la Sitemap XML

La sitemap XML è una mappa del tuo sito che aiuta il Googlebot a trovare tutte le pagine importanti. Puoi inviarla attraverso la Google Search Console, garantendo che il bot sappia esattamente dove cercare i contenuti principali.

Per un’efficace ottimizzazione:

- Aggiorna la sitemap regolarmente quando aggiungi o rimuovi pagine.

- Includi solo URL di alta qualità che vuoi indicizzare.

Ottimizzare per il Googlebot Mobile

Con l’approccio mobile-first indexing, Google utilizza principalmente la versione mobile del tuo sito per il crawling e l’indicizzazione. Per evitare problemi:

- Verifica che il sito sia responsive e si adatti perfettamente a schermi di ogni dimensione.

- Controlla che tutti i contenuti e le funzionalità siano accessibili anche da dispositivi mobili.

- Usa la Google Search Console per eseguire test di compatibilità mobile.

Quanto è importante sapere cosa fa il crawler di Google?

Il Googlebot è una delle colonne portanti, ed è essenziale per chiunque gestisca un sito web comprendere il suo funzionamento. Non si tratta solo di “piacere” a Google, ma di rendere il proprio sito accessibile, organizzato e utile, sia per gli utenti che per il motore di ricerca.

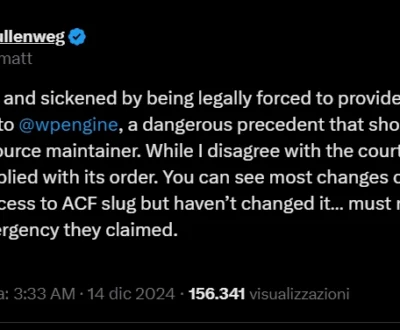

A mio discapito posso dire che il Googlebot è un’arma a doppio taglio: da un lato, la sua capacità di scansionare e indicizzare miliardi di pagine è impressionante, dall’altro, può diventare un ostacolo se il sito non è ottimizzato a dovere. La SEO non è solo tecnica, non è solamente SEO on-page e acquisizione di backlink ma richiede una strategia chiara e un impegno continuo per migliorare contenuti, struttura e prestazioni. Troppo spesso vedo siti pieni di valore essere penalizzati da piccoli errori evitabili, come una configurazione errata del file robots.txt o una gestione superficiale del crawl budget.

Ciò che mi affascina del Googlebot è che rappresenta un riflesso della qualità complessiva del web: se il tuo sito è ben costruito, accessibile e utile, sarà premiato. Se invece è disordinato o lento, nessuna tecnica SEO potrà compensare le lacune. Ecco perché credo che lavorare con il Googlebot non significhi solo ottimizzare per un algoritmo, ma costruire un’esperienza migliore per chi visita il tuo sito.

Se impari a usarlo correttamente, può diventare il tuo miglior alleato nel posizionarti in alto nei risultati di ricerca e nel raggiungere il pubblico giusto.

La chiave è mantenere una mentalità proattiva, monitorare costantemente il sito e accogliere i cambiamenti come un’opportunità per migliorare.